前言

2025年春节期间DeepSeek就突然火了。令人印象深刻的是它完全开源,加之超群的推理能力和非常有竞争力的价格,全球老外都很喜欢,最终导致老美拿出了当年对付华为的那一套东西制裁DeepSeek。

如此以来,DeepSeek非但没被打压,反而更火了,泼天的富贵(流量)涌入DeepSeek官方,造成官方长达“一年”(春节前噶了,春节后还是噶的,四舍五入就按一年算吧哈哈)的服务故障。

后续各大厂商也各种作妖蹭DeepSeek的流量,割韭菜卖课的也接踵而至,这就不展开说了,总结下来就是我们作为普通用户一定要理性消费,毕竟挣个钱都不容易~

本文将介绍一种开源推理模型DeepSeek-R1本地部署的方法。请注意,本文是基于以下配置进行的安装:

- Windows电脑

- CPU:Intel(R) Core(TM) i9-14900HX 2.20 GHz

- 显卡:NVIDIA GeForce RTX 4060 Laptop GPU

- 内存:16GB

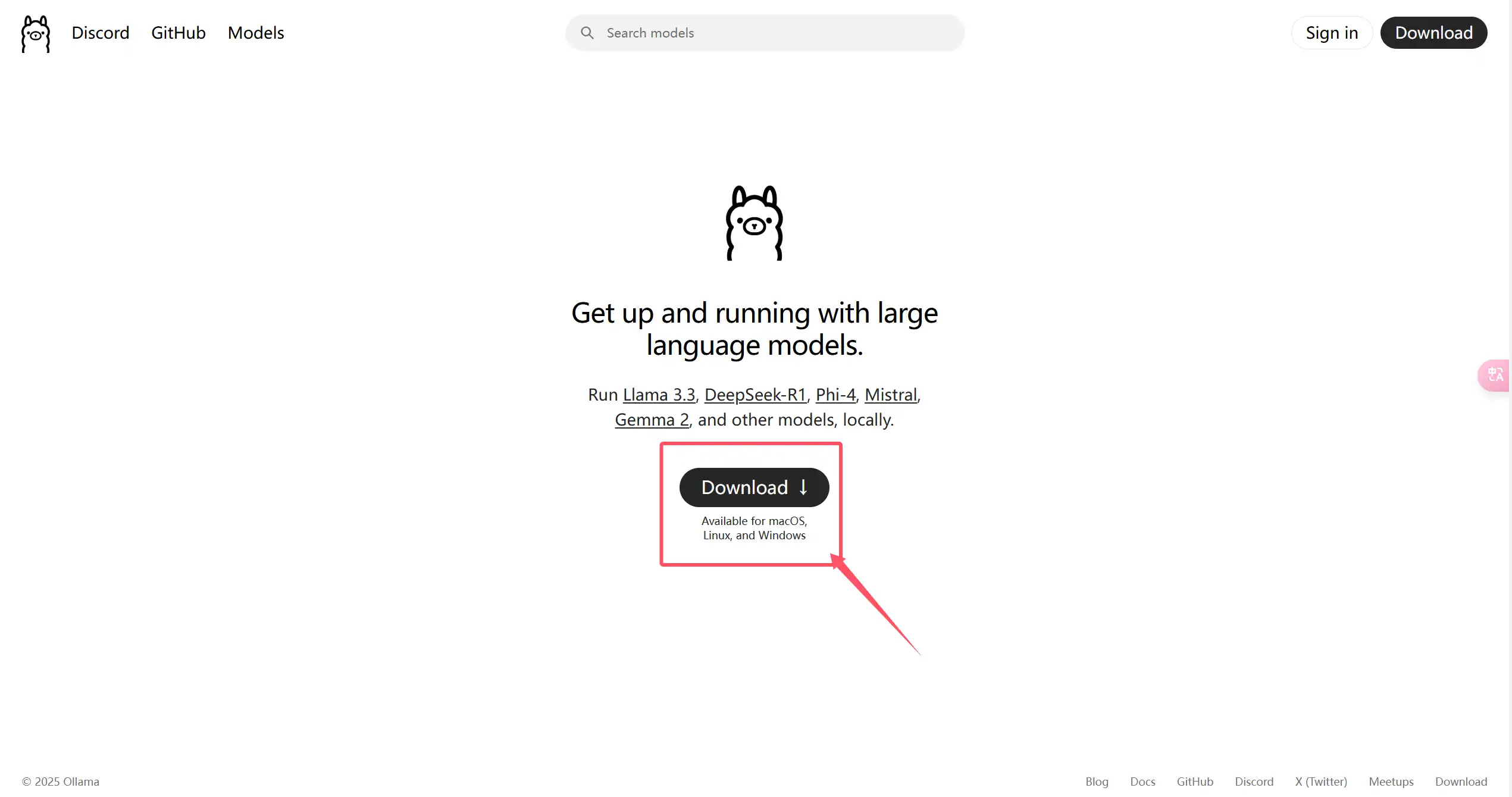

安装Ollama

Ollama客户端是运行开源大模型的基础程序。前往Ollama官网,下载安装程序并双击安装即可。

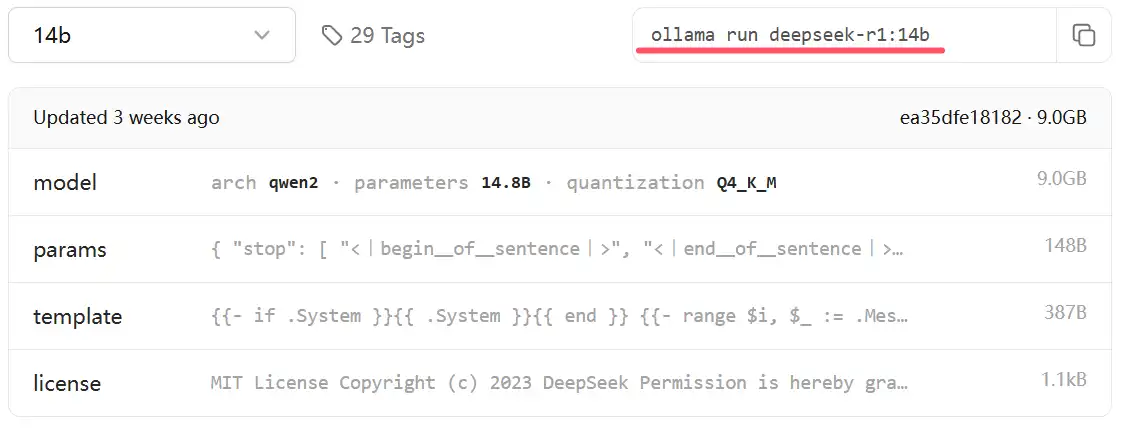

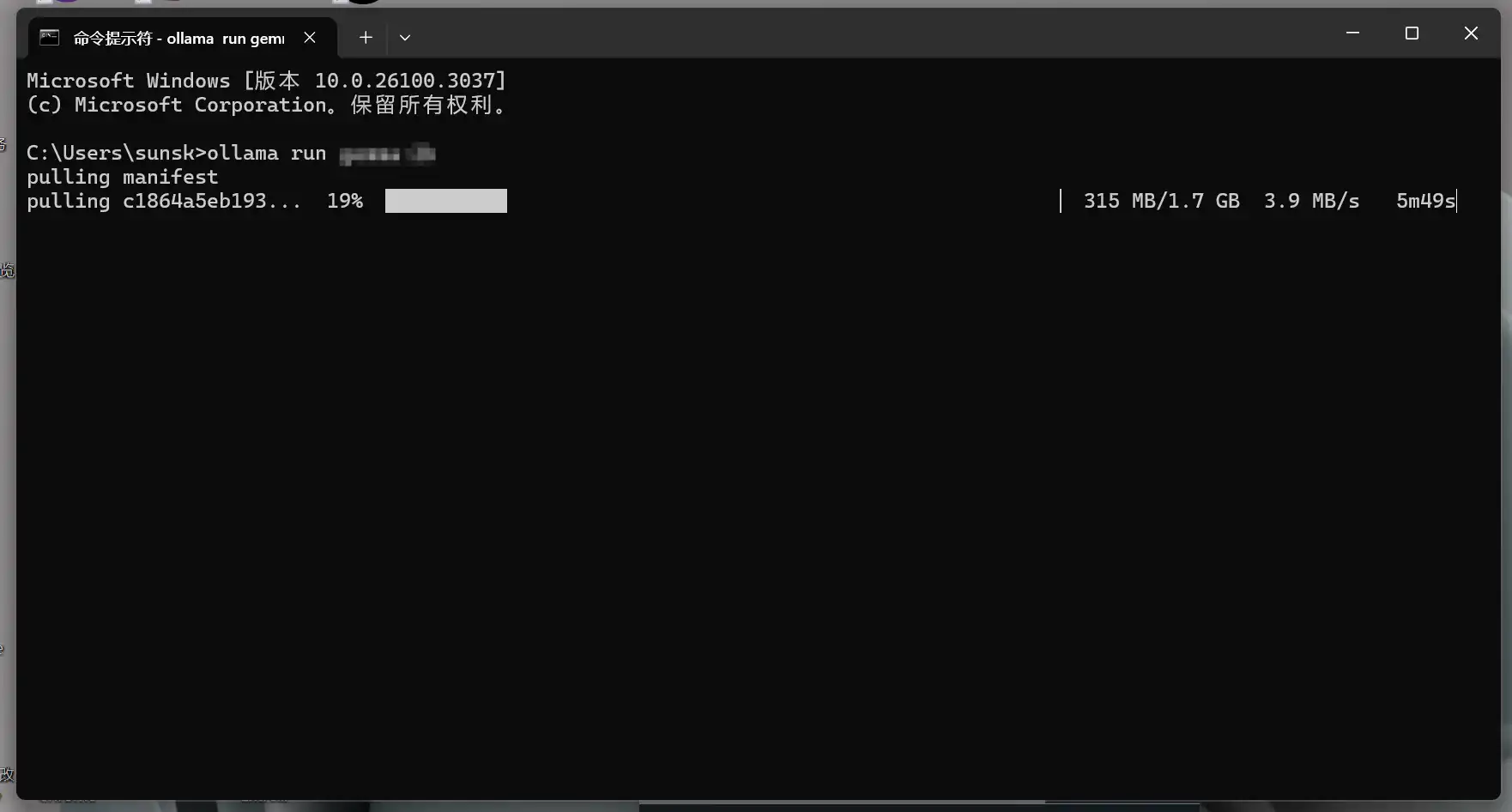

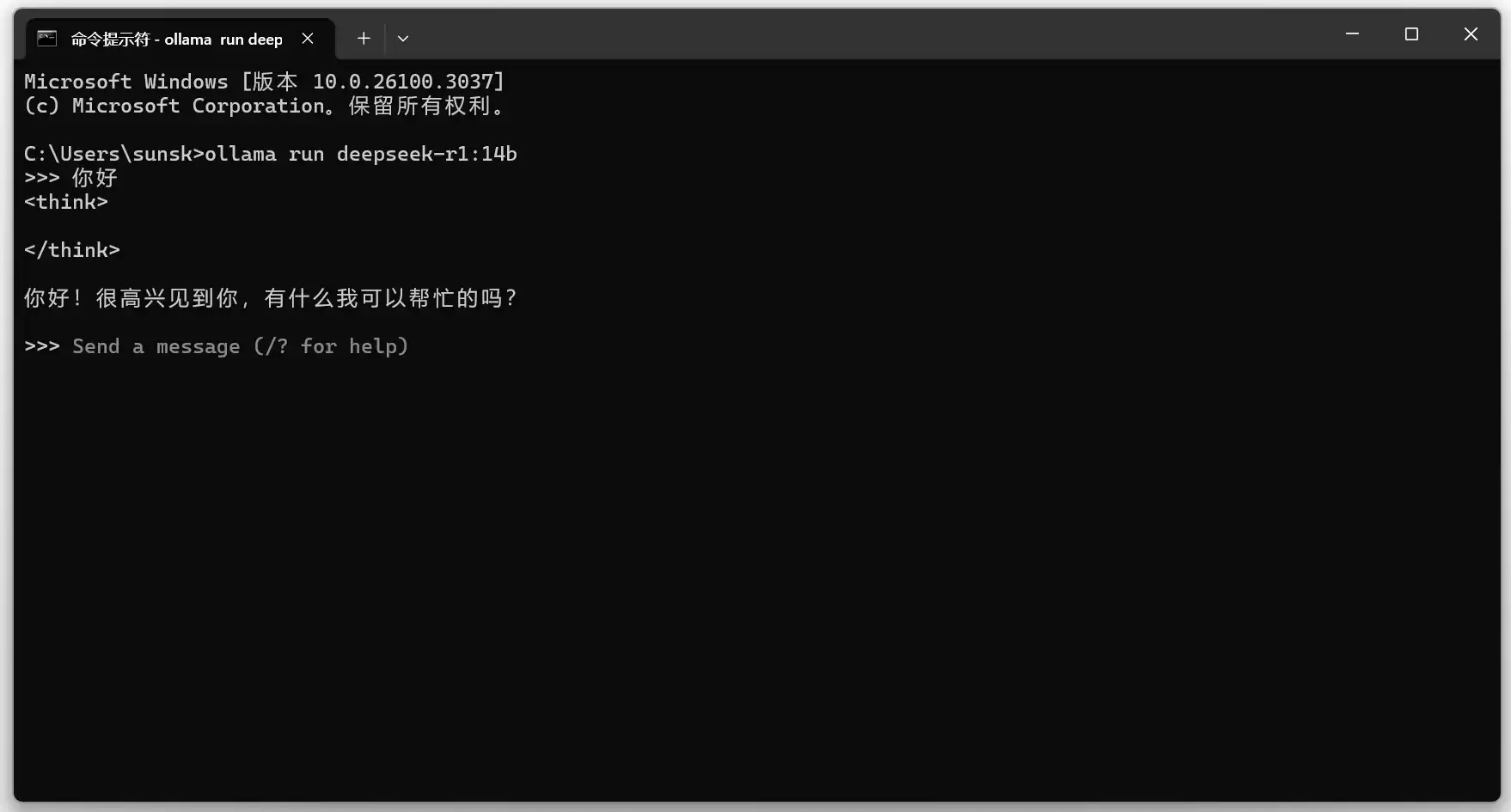

安装DeepSeek-R1

安装Cherry Studio

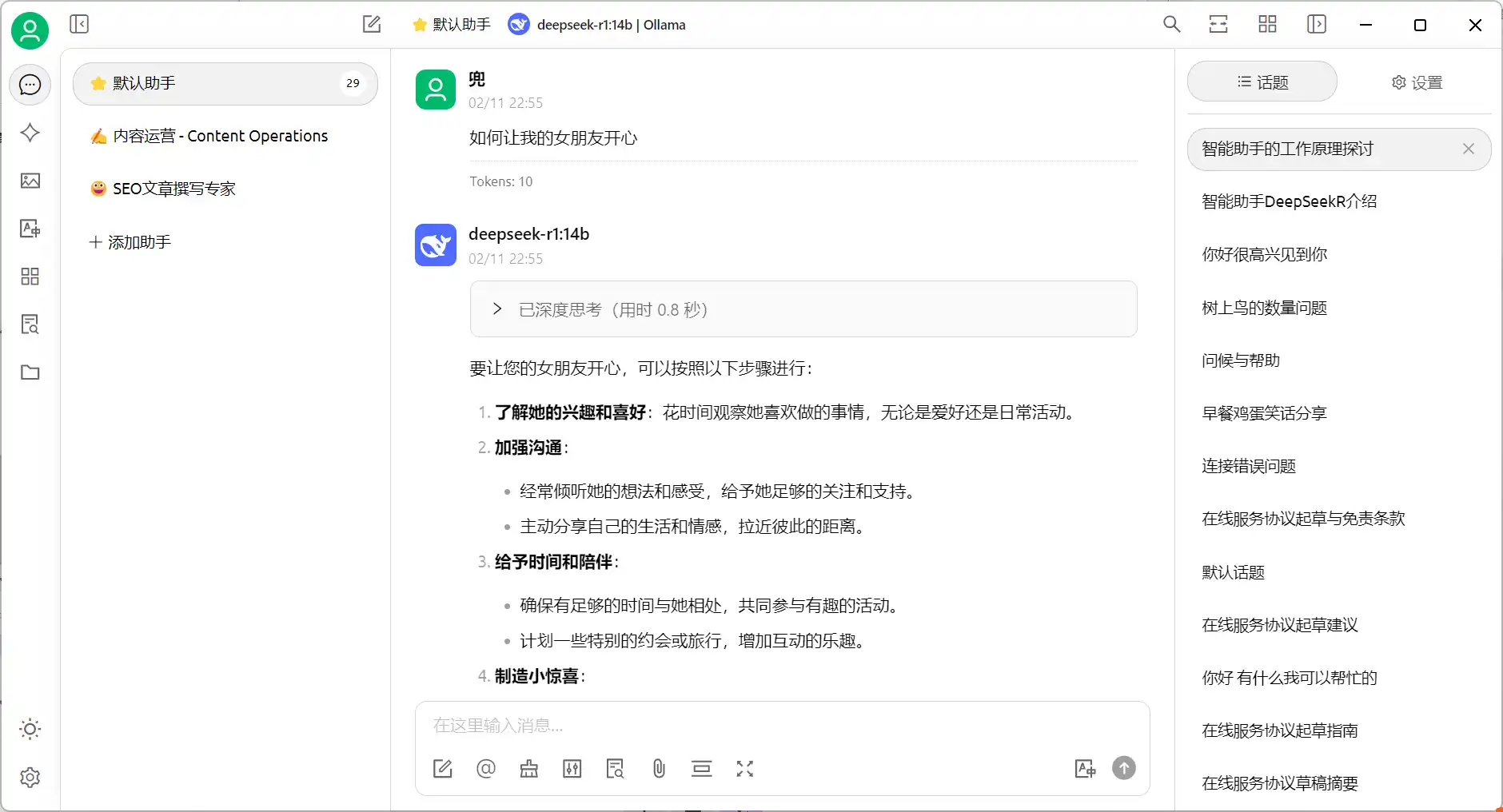

Cherry Studio是一个非常好用的AI前端程序,有了它就可以不用终端进行对话了。

访问CherryStudio官方网站,并下载安装程序,详细的使用教程可以参考我的文章《CherryStudio安装及介绍教程》。

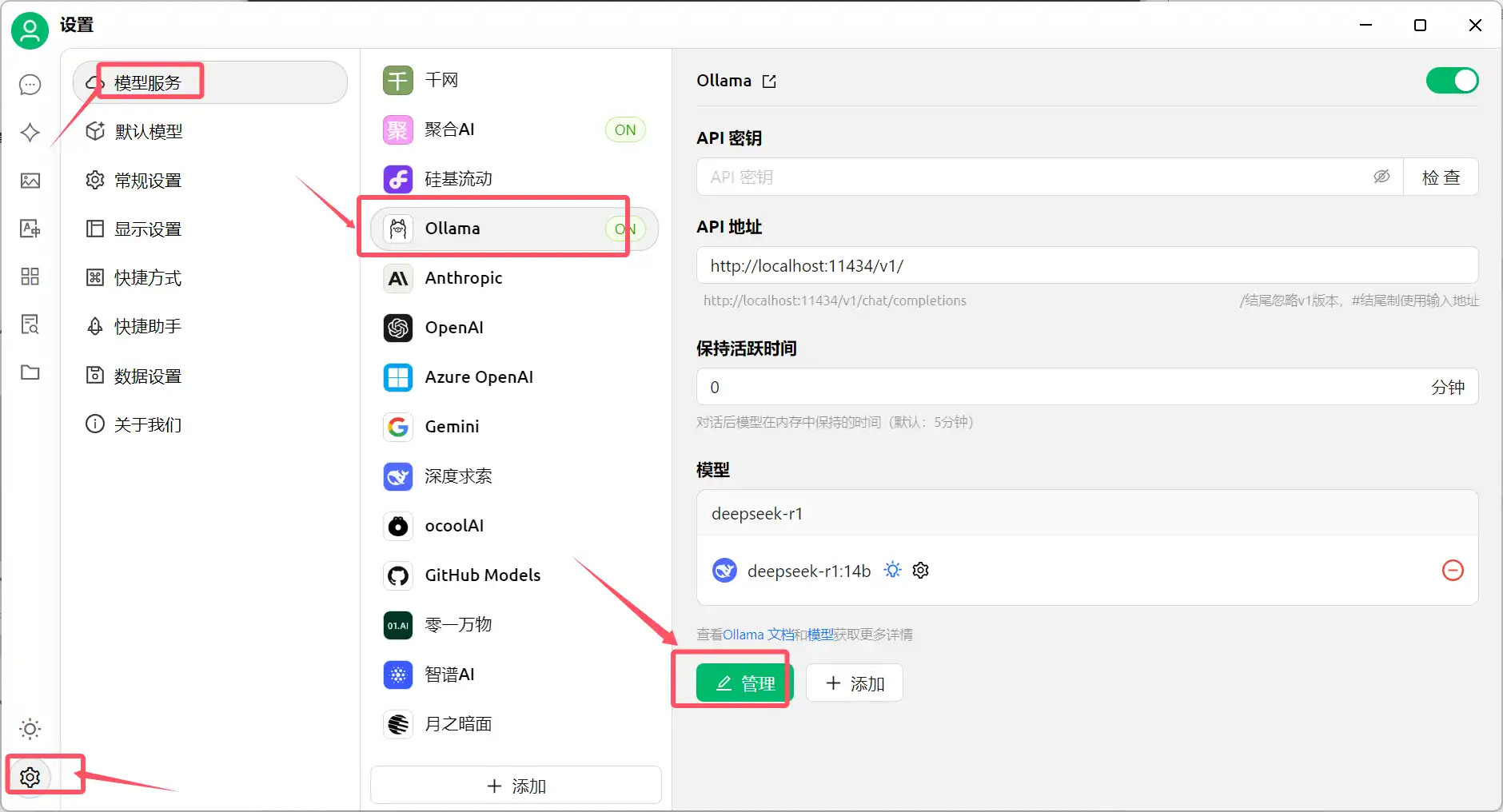

安装完成后,在设置中找到Ollama,并在管理中添加DeepSeek-R1:14b模型即可开始使用。

补充方案

本地部署非常依赖电脑配置,像满血版本671b在本地电脑部署几乎不可能(需求数十张H100显卡集群),只适合处理翻译、小型数据任务等,如需满血版本模型,可以借助api实现,除DeepSeek官方以外(经常故障,目前已关闭充值服务),以下是额外两家提供满血版本api的服务商,可根据需要选择:

1、硅基流动(https://siliconflow.cn/)

硅基流动几乎提供市面上可见的所有开源大模型,价格极低,调用方便,如需可以前往购买,新用户还有免费额度。缺点是对并发有调用限制,不适合低消费用户高并发场景。硅基也没有海外闭源模型,如gpt、claude、gemini系列等。

2、聚合AI(https://juheai.vjjwz.cn/)

聚合AI几乎提供全球所有的开源和闭源模型,包括海外比较知名的gpt、claude、gemini、midjourney,国内DeepSeek及其它大模型厂商的模型,包括满血版DeepSeek-R1和DeepSeek-V3,无并发限制,稳定性高,可用于学习或生产环境。缺点是价格略高一些。

聚合AI在Cherry Studio中的设置方法参考此处>>

更多AI应用文章请收藏本站,您还可以关注我们的微信公众号获取最新内容:产品试金石